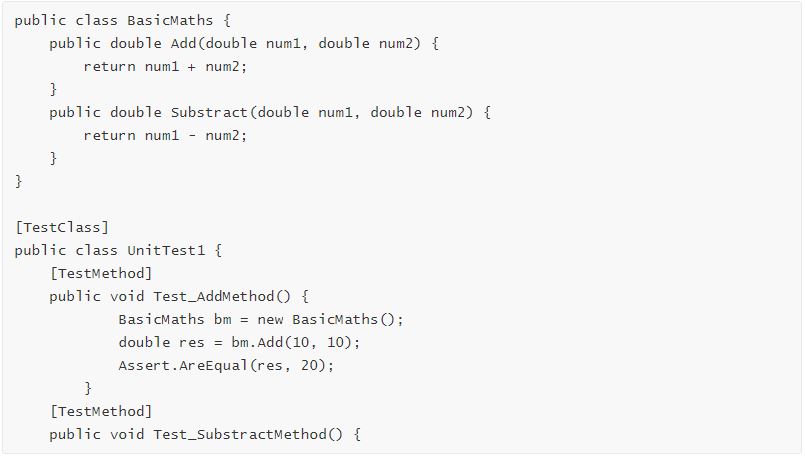

Wanneer we naar de output kijken zien we dat het model de juiste methode kiest, en vervolgens ook snapt dat de uitkomst niet gelijk moet zijn aan het voorgaand voorbeeld, maar aan nul in plaats van twintig.

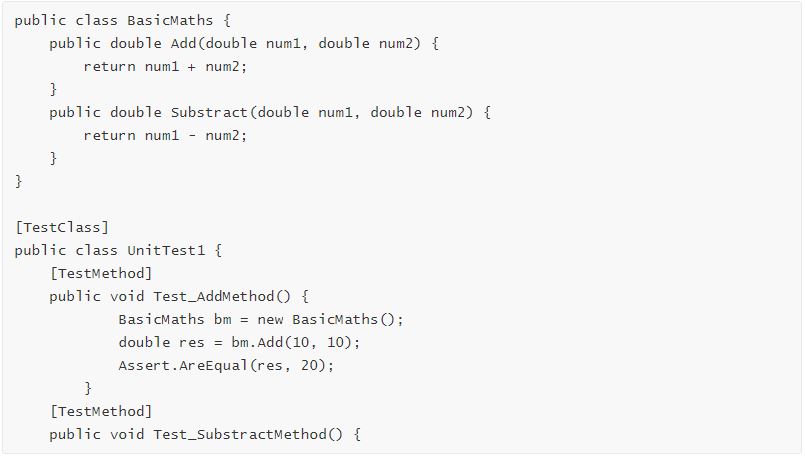

Laten we het eens proberen zonder een voorbeeld, met enkel de code als input en de aanzet naar een test case.