Op GDC dit jaar presenteerde Eidos Montreal hun workflow voor animaties voor "Guardians of the Galaxy." Ze deden dit binnen twee talks, een eerste focuste op de facial animation pipeline, en een tweede, de focus van deze blogpost, ging over het toevoegen van emotional body language bovenop locomotion. (Deze talks zitten weliswaar achter de GDC Vault paywall.)

Een van de pijlers van "Marvel's Guardians of the Galaxy" game was dat ze de speler het gevoel wilden geven dat ze echt met de Guardians op pad waren. Om dit te bereiken, en om de characters echt tot leven te brengen maken ze gebruik van veel humor tussen de verschillende characters. Om herhaling te voorkomen moesten de animators enorm veel diverse animatie content creëren, niet alleen in cinematics, maar ook tijdens gameplay. Dit soort animaties kunnen niet gescript worden, hetwelke een echte uitdaging is binnen het production budget. Kortweg: ze moesten slim omgaan met de resources die ze hadden.

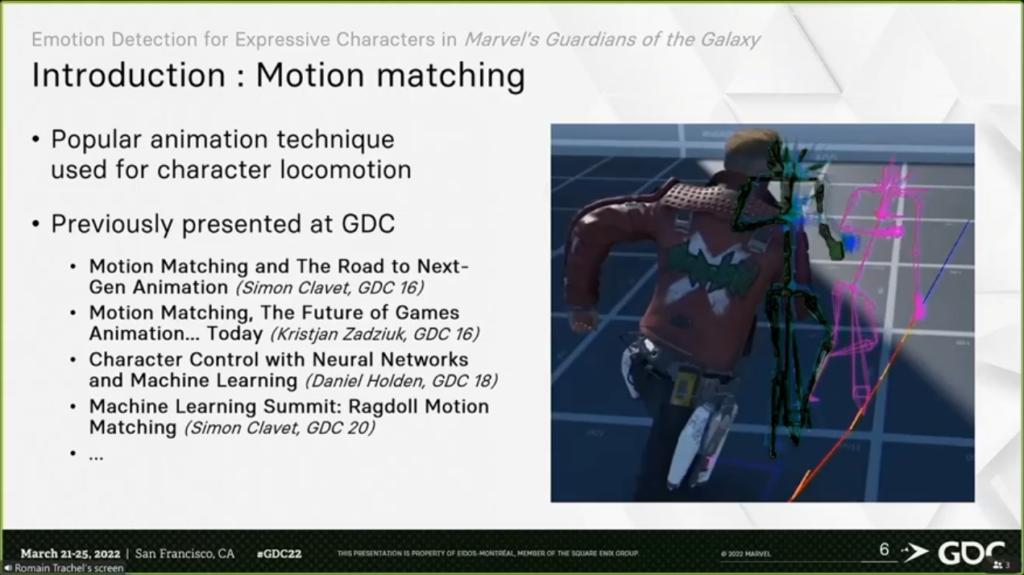

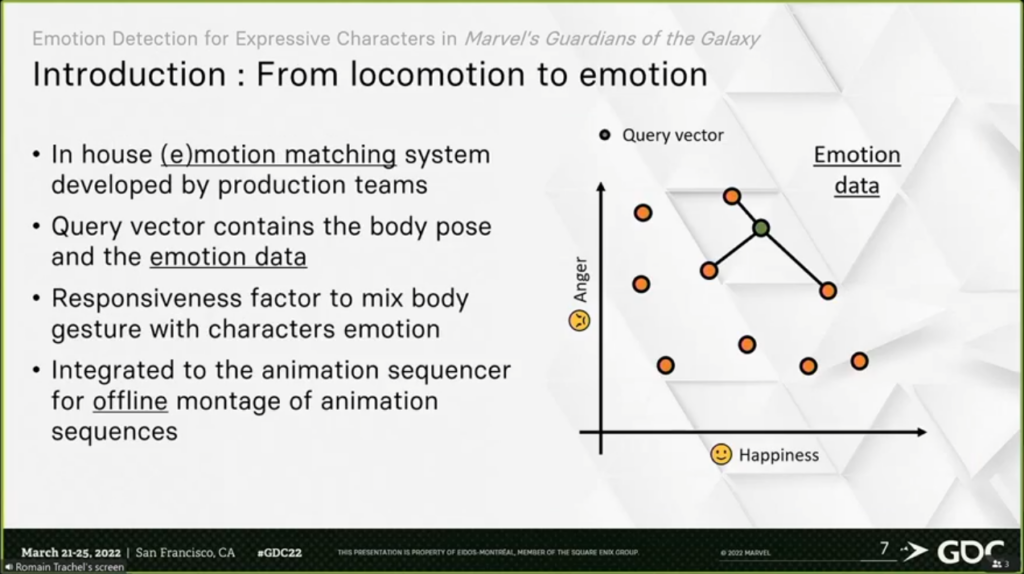

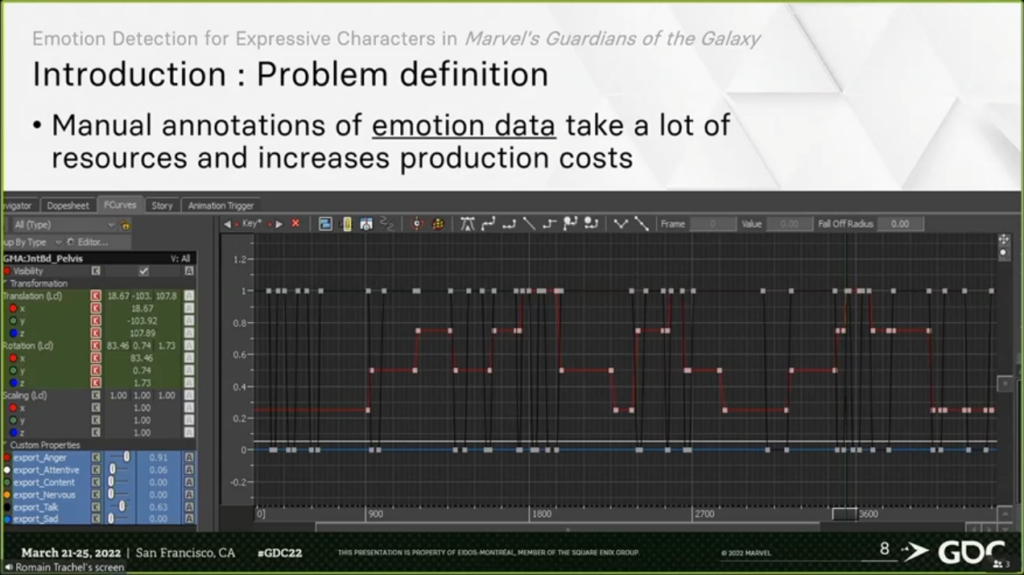

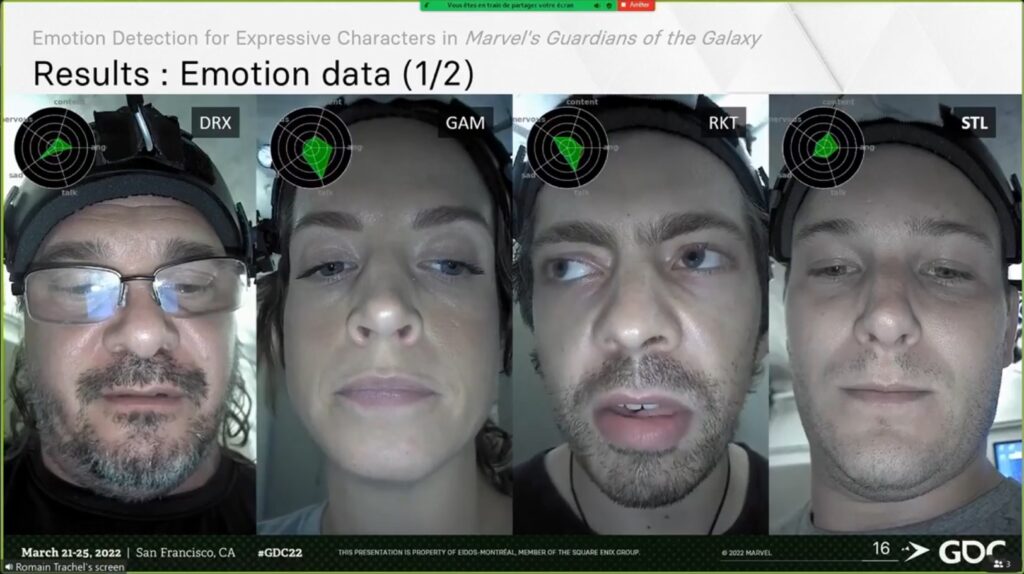

Om dit te bereiken maakten ze gebruik van een nieuwe animation technique gebaseerd op Machine Learning!

Motion Capture

Om animaties op te nemen maakten ze gebruik van zowel facial als full-body motion capture. Specifiek maakten ze gebruik van Faceware voor de facial tracking, en een Optitrack systeem voor de Full-Body capture. Ze kozen ervoor om de voiceline audio tegelijkertijd op te nemen als de facial animations, en deze dus niet "procedureel" te genereren. Elke facial animation werd uniek opgenomen.