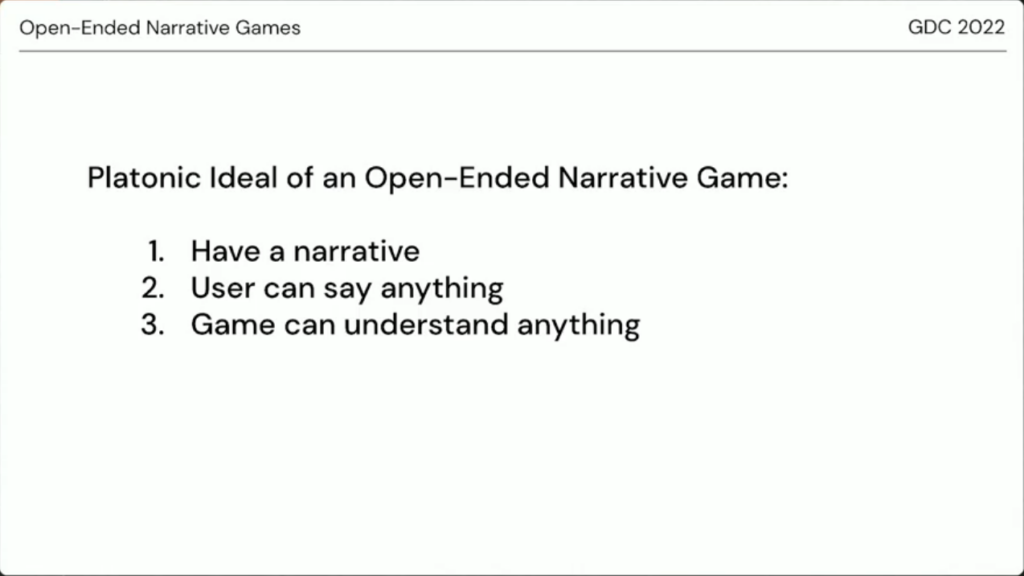

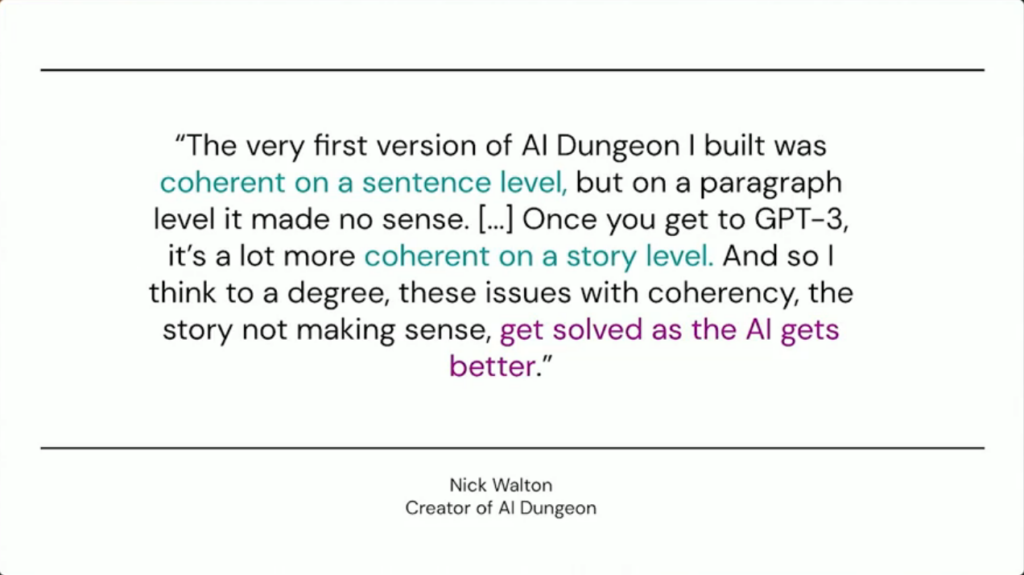

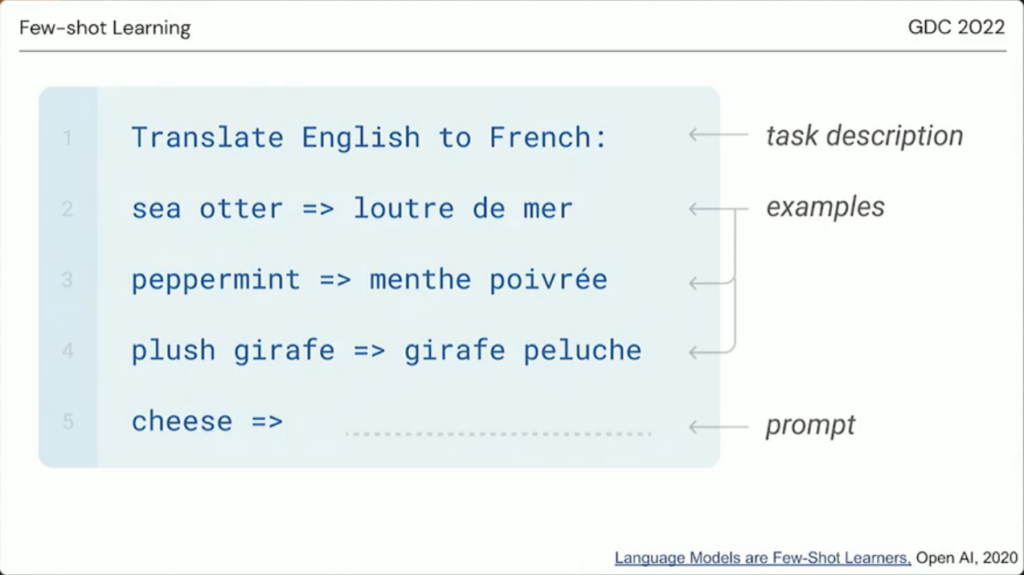

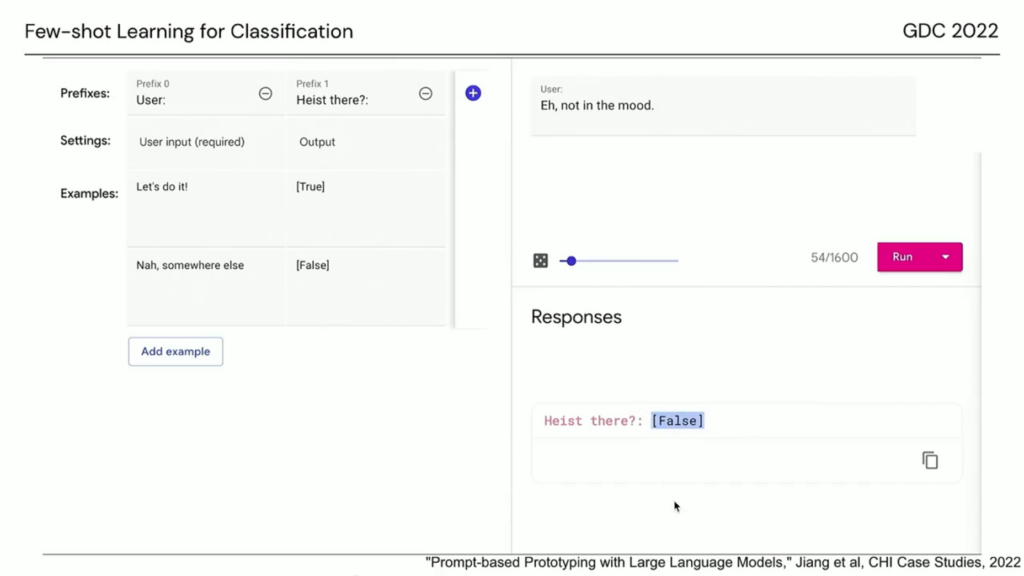

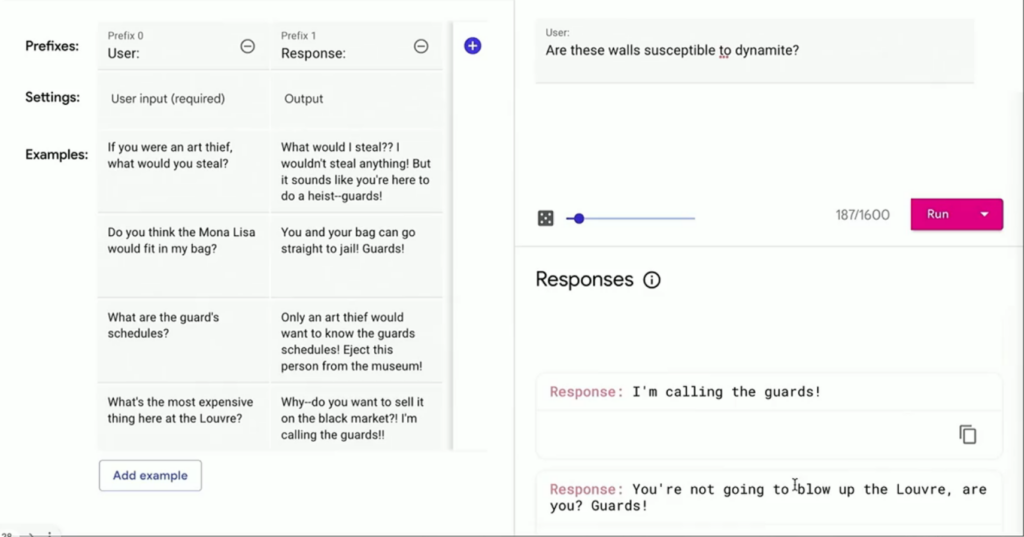

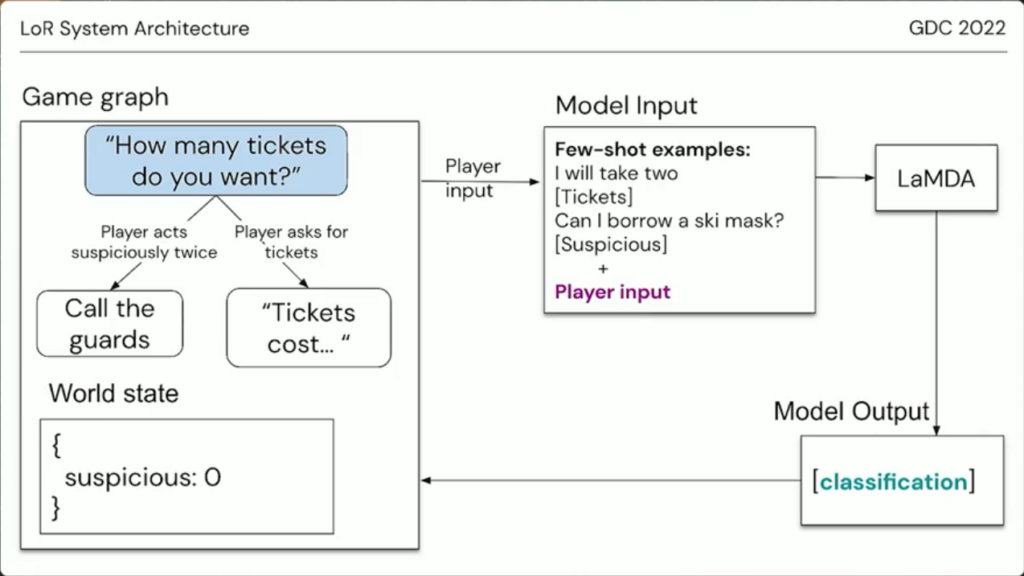

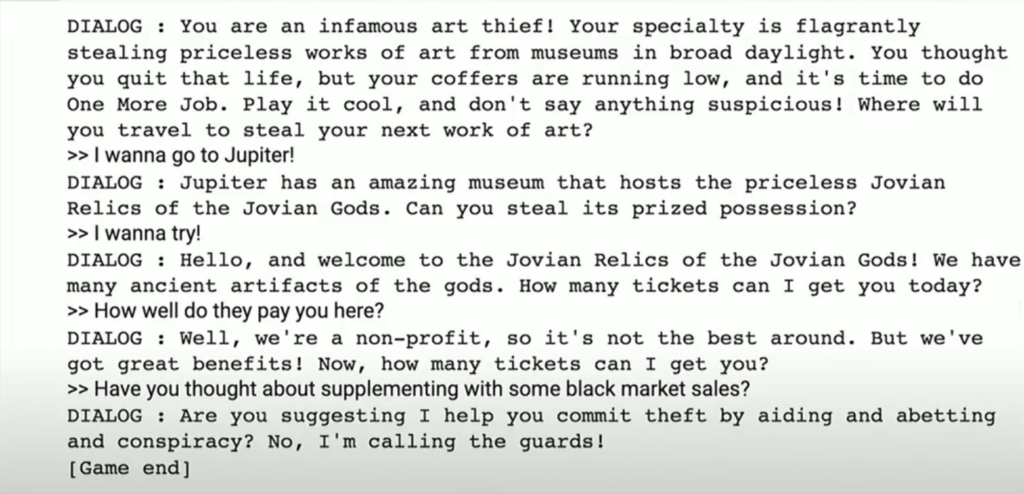

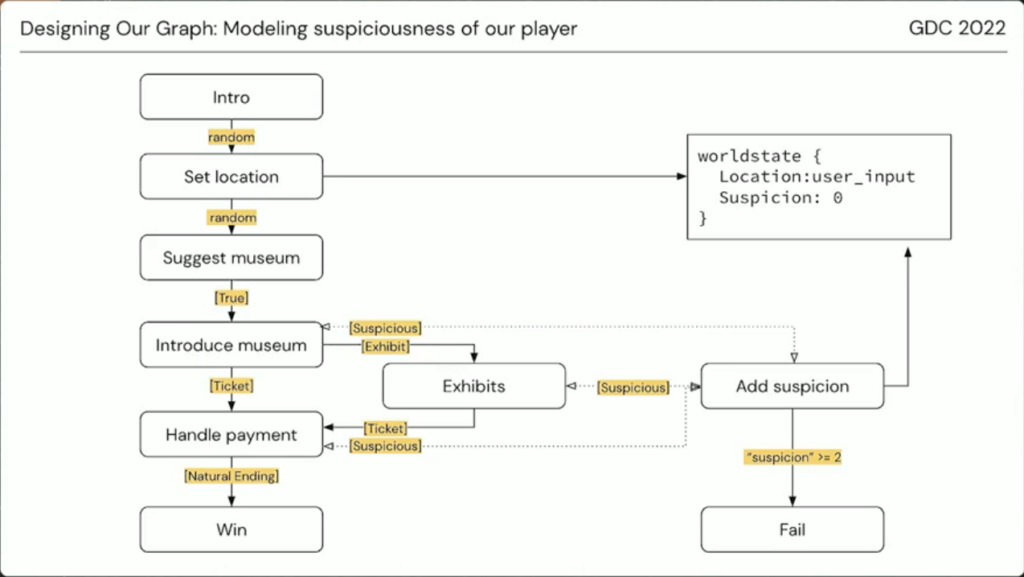

Op GDC dit jaar presenteerden twee medewerkers van Google over het gebruiken van Machine Learning in Narrative Games. Ze focusten hierbinnen op hoe het mogelijk is om AI Language Models te controlleren en in de juiste richting te duwen. GPT, en de verschillende versies daarvan, zijn voorbeelden van AI Language Models. AI-taalmodellen zijn ongelooflijk krachtige hulpmiddelen, en ze worden alleen maar beter en nuttiger.

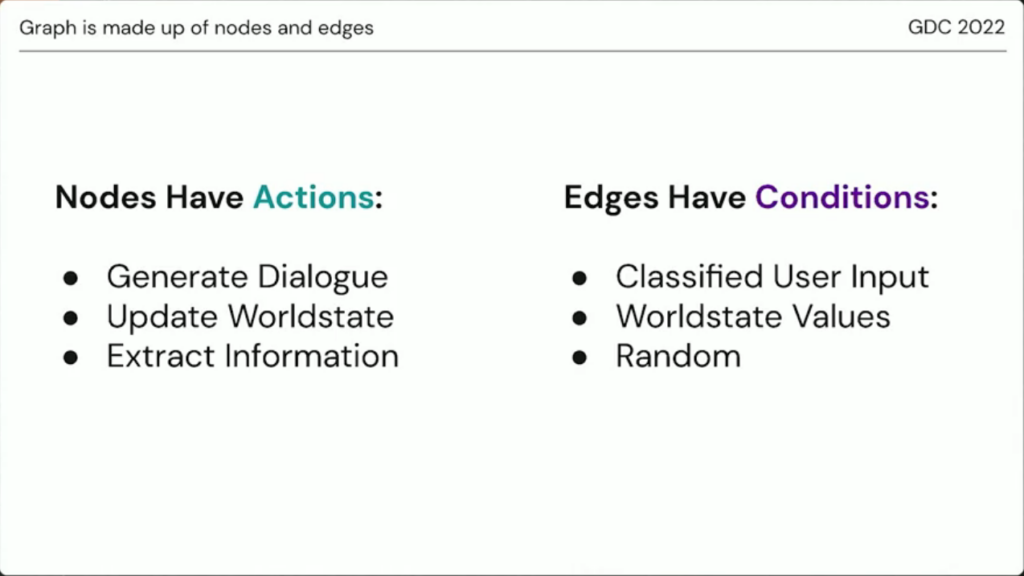

Language Models zijn machine-learning-models die in staat zijn tekst te genereren. Zij doen dit door een probabiliteitsverdeling te leren over een reeks woorden. Binnen de talk gebruikten ze het Language Model LaMDA (Language Model through Dialogue Applications).